Was hat die Turing-Maschine mit KI-Modellen zu tun?

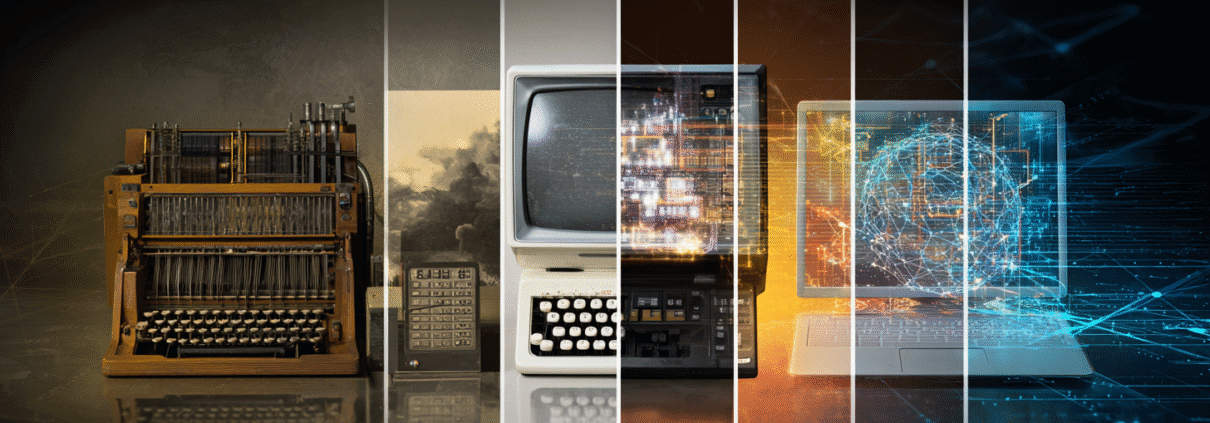

Die Geschichte der modernen Computertechnologie ist eine Blaupause für die Entwicklung von KI-Modellen hin zu kleineren, effizienteren und besser zugänglichen Systemen. Dort zeigt sich eine bemerkenswerte Parallele:

Alan Turing legte 1936 mit seiner universellen Rechenmaschine, der Turing-Maschine, den Grundstein für alle späteren Entwicklungen im Bereich der Computertheorie. Diese abstrakte Maschine definierte erstmals klar, was berechenbar ist und schuf damit eine theoretische Grundlage für sämtliche nachfolgenden Computerentwicklungen.

Von raumfüllender Rechenmaschine zur Hosentaschentechnologie

Ausgehend von Turings Konzept entstanden in den 1940er- bis 1960er-Jahren gewaltige Mainframe-Rechner wie der ENIAC oder IBM-Großrechner, die ganze Räume füllten und enorm viel Energie verbrauchten.

Durch Innovationen wie integrierte Schaltkreise und Mikroprozessoren schrumpften Computer jedoch kontinuierlich und wurden zunehmend zugänglicher. In den 1970er- und 1980er-Jahren erschienen erste Personal Computer wie der Apple II, die Rechenleistung und Funktionalität zu den Menschen nach Hause brachten.

Mit der Einführung der Smartphones, etwa des iPhones von Apple oder Android-Geräten wurde diese Technologie schließlich vollkommen mobil und für alle nutzbar.

Genau diese Entwicklung wiederholt sich nun in der Welt der KI-Modelle. Ursprünglich waren KI-Systeme wie GPT-Modelle oder Googles BERT extrem komplex und liefen ausschließlich in großen Rechenzentren. Heute werden KI-Modelle zunehmend kleiner, effizienter und damit alltagstauglicher.

Hardware als Vorbild für zukünftige KI-Modelle

Frühe KI-Modelle benötigten enorme Datenmengen, Milliarden von Parametern und teure Infrastruktur. Durch technologische Fortschritte wie Knowledge Distillation, Quantisierung, Pruning und der innovativen Mixture-of-Experts-Architektur (MoE) werden Modelle heute jedoch kompakter und effizienter. Modelle wie DeepSeek oder Mistral liefern hervorragende Ergebnisse mit deutlich weniger Parametern und funktionieren sogar auf mobilen Endgeräten. Die Miniaturisierung der KI-Technologie macht sie damit nicht mehr nur großen Unternehmen zugänglich, sondern einem viel breiteren Publikum.

Kleine KI-Modelle auf dem Vormarsch

Aktuell gibt es mehrere technologische Ansätze, die KI-Modelle kompakter, effizienter und gleichzeitig leistungsfähig gestalten.

Ein besonders erfolgreicher Ansatz ist die sogenannte Knowledge Distillation (Wissensdestillation). Dabei wird das Wissen großer KI-Modelle, die über Milliarden Parameter verfügen, auf kleinere, kompaktere „Schüler-Modelle“ übertragen.

Das Prinzip funktioniert ähnlich wie das Verhältnis eines Lehrers zu einem Schüler: Das große Modell trainiert ein kleineres Modell, sodass dieses mit weit weniger Ressourcen und Parametern ähnliche Ergebnisse liefert. Der Vorteil dieser Methode liegt darin, dass kleinere Modelle deutlich weniger Rechenleistung und Energie verbrauchen, und dabei nahezu die gleiche Qualität aufweisen.

Die Techniken des Prunings und der Quantisierung setzen hingegen direkt an der Optimierung der bestehenden Modelle an. Beim Pruning werden überflüssige oder unwichtige Parameter aus dem Modell entfernt, was die Komplexität reduziert. In Kombination mit Quantisierung, der Reduzierung der Genauigkeit von numerischen Berechnungen, verringert sich der Speicherbedarf massiv.

Modelle, die diese Techniken nutzen, laufen so deutlich schneller, verbrauchen weniger Strom und können auch lokal auf Smartphones oder IoT-Geräten eingesetzt werden.

Ein weiterer bahnbrechender Ansatz ist die MoE-Architektur, bei der Modelle in mehrere spezialisierte Teilnetzwerke (sogenannte „Experten“) aufgeteilt sind. Das Besondere: Je nach Eingabe werden zur Laufzeit nur diejenigen Experten aktiviert, die wirklich relevant sind. Dadurch sinkt der Aufwand pro Anfrage deutlich, da nicht sämtliche Parameter des Modells genutzt werden müssen. Diese Architektur erlaubt es großen Modellen, gleichzeitig kompakt und effizient zu sein, ohne Abstriche bei der Genauigkeit zu machen.

Schließlich gewinnt die Entwicklung sogenannter TinyML-Modelle stark an Bedeutung. TinyML steht für ultrakleine, hochspezialisierte KI-Modelle, meist mit weniger als einer Million Parametern, die direkt auf Mikrocontrollern, kleinen Geräten und Sensoren laufen können.

Ein populäres Beispiel ist der TinyTimeMixer von IBM, der extrem ressourceneffizient ist und somit KI-Technologie selbst in Umgebungen verfügbar macht, in denen traditionelle KI-Systeme aufgrund ihrer Größe und ihres Stromverbrauchs bisher nicht einsetzbar waren.

Die Demokratisierung der KI beginnt jetzt

Die zunehmende Verkleinerung von KI-Modellen hat weitreichende gesellschaftliche Auswirkungen und führt zu einer Demokratisierung der Künstlichen Intelligenz.

Technologie, die zuvor großen Unternehmen vorbehalten war, wird nun kleinen Unternehmen, Start-ups und Privatpersonen zugänglich gemacht. Lokale KI-Modelle verringern Abhängigkeiten von großen Cloud-Anbietern, verbessern den Datenschutz und erweitern so die Anwendungsfelder deutlich.

Der stärkere Wettbewerb und neue Innovationen sind ein weiterer Effekt der Demokratisierung. Kleine, spezialisierte Unternehmen haben die Chance, durch eigene, lokal nutzbare KI-Lösungen wettbewerbsfähiger zu werden und neue Geschäftsfelder zu erschließen.

Zusammengefasst bedeutet diese Entwicklung hin zu kompakten KI-Modellen nicht nur technologischen Fortschritt, sondern auch eine gerechtere und inklusivere Nutzung von KI-Technologien.

Technologischer Fortschritt wird nicht durch Größe definiert

Die Parallelen zwischen der Entwicklung von Computerhardware und KI-Modellen zeigen eindrucksvoll, dass technologischer Fortschritt nicht allein durch Größe und Komplexität definiert wird. Wie bei Computern folgt die KI-Entwicklung dem Muster, dass echter Durchbruch durch Miniaturisierung, Optimierung und breite Zugänglichkeit entsteht.

Standen am Anfang riesige Großrechner, denen später kleinere, erschwingliche Personal Computer folgten, so kulminierte diese Entwicklung schließlich in der alltäglichen Nutzung moderner Smartphones. Analog dazu zeigt sich auch in der KI-Entwicklung ein klarer Trend weg von großen, komplexen Modellen hin zu kompakteren, spezialisierten und lokal einsetzbaren KI-Lösungen.

Diese Entwicklung wird in Zukunft noch weiter an Bedeutung gewinnen. KI wird zunehmend zu einer Alltagsressource, die jeder auf dem Smartphone, der Smartwatch oder in den IoT-Geräten stets griffbereit haben wird. So wie es heute selbstverständlich ist, dass man jederzeit und überall einen leistungsfähigen Computer in der Tasche trägt. Dabei ist besonders bemerkenswert, dass durch diese Miniaturisierung und Dezentralisierung von KI-Technologie auch deren gesellschaftliche Reichweite erheblich zunimmt. KI wird nicht nur technologisch zugänglicher, sondern auch sozial fairer verteilt und vielfältiger nutzbar.

targenio Assistenten-Plattform als Wegbereiter

Um mit diesen rasanten technologischen Entwicklungen Schritt zu halten, ermöglicht unsere targenio Assistenten-Plattform eine einfache Integration verschiedenster KI-Modelle. Die Plattform ist so gestaltet, dass sie flexibel jedes neue KI-Modell aufnehmen kann. Egal, welche innovativen Modelle zukünftig entwickelt werden, unsere Plattform bleibt stets aktuell und einsatzbereit.

Du willst mehr darüber erfahren, wie unsere Assistenten-Plattform auch deinen Service zukunftsfähig macht? Kontaktier uns, wir freuen uns auf das Gespräch!

Image: KI-generiert

KI-generiert

KI-generiert

KI-generiert

KI-generiert